FRA1-1 Cloud - Zugriff auf die GPU

Die folgende Dokumentation beschreibt den virtuellen GPU-Zugriffsmodus in der FRA1-1-Cloud.

Der Unterschied zwischen GPU-Passthrough (PT) und vGPU-Modi

Bis Mitte 2023 wurden GPU-Instanzen auf der FRA1-1 Cloud im Pass-Through-Modus gestartet, was bedeutet, dass eine gesamte physische GPU direkt einer virtuellen Maschine (VM) zugewiesen wurde. Der Zugriff auf die gesamte GPU erfolgt ausschließlich durch den NVIDIA-Treiber, der in der entsprechenden VM läuft. Die GPU wird nicht zwischen VMs geteilt.

NVIDIA Virtual GPU (vGPU) ermöglicht mehreren virtuellen Maschinen den gleichzeitigen, direkten Zugriff auf einen einzigen physischen Grafikprozessor, wobei dieselben NVIDIA-Grafiktreiber verwendet werden, die auch auf nicht virtualisierten Betriebssystemen zum Einsatz kommen. Auf diese Weise bietet NVIDIA vGPU den virtuellen Maschinen eine beispiellose Grafikleistung, Rechenleistung und Anwendungskompatibilität sowie die Kosteneffizienz und Skalierbarkeit, die durch die gemeinsame Nutzung eines Grafikprozessors durch mehrere Workloads erreicht wird. Diese Implementierung erfolgt mit zwei Virtualisierungsmodi und speziellen NVIDIA Grid-Treibern.

Eingeführte Änderungen

Im Pass-Through-Modus standen Anwendern zwei Varianten für ihre Instanzen zur Verfügung, die auf NVIDIA A100- und RTX A6000-Grafikkarten basieren, mit den folgenden Konfigurationen:

Flavor Name |

vCPU |

RAM |

Disk |

|---|---|---|---|

gpu.a100 |

24 |

118 GB |

64 GB |

gpu.a6000 |

24 |

118 GB |

800 GB |

Beide Varianten wurden so konfiguriert, dass eine ganze physische GPU einer VM zugewiesen wurde. Zusätzlich musste der Benutzer die Instanz konfigurieren, was die Installation von NVIDIA-Treibern und optionalen CUDA-Tools beinhaltete.

Mittlerweile stehen neue Varianten in der Cloud bereit. Für eine bessere Nutzung der Rechenleistung werden Instanzen, die auf vGPU-Flavors basieren, Zugang zu lokalem Hochgeschwindigkeits-SPDK-Speicher auf Basis von NVMe-Festplatten haben.

A100

Die A100-GPU-Karte arbeitet im MIG-Virtualisierungsmodus (Multi-Instance GPU).

Im MIG-Modus können mehrere vGPUs (und damit VMs) parallel auf einem einzigen Grafikprozessor ausgeführt werden, so dass mehreren Anwendern separate GPU-Ressourcen für eine optimale GPU-Auslastung zur Verfügung stehen.

Flavor Name |

vCPU |

RAM |

Disk |

|---|---|---|---|

vm.a100.1 |

1 |

14 GB |

40 GB |

vm.a100.2 |

3 |

28 GB |

40 GB |

vm.a100.3 |

6 |

56 GB |

80 GB |

vm.a100.7 |

12 |

112 GB |

80 GB |

A6000

RTX A6000-Karten arbeiten im Time-Sliced-Virtualisierungsmodus.

Im Time-Sliced-Modus erhält jede Instanz ihr eigenes separates VRAM-Slice, während die GPU-Zeit durch den Scheduler zwischen den Instanzen aufgeteilt wird.

Flavor Name |

vCPU |

RAM |

Disk |

|---|---|---|---|

vm.a6000.1 |

1 |

14 GB |

40 GB |

vm.a6000.2 |

3 |

28 GB |

40 GB |

vm.a6000.4 |

6 |

56 GB |

80 GB |

vm.a6000.8 |

12 |

112 GB |

80 GB |

VM Images

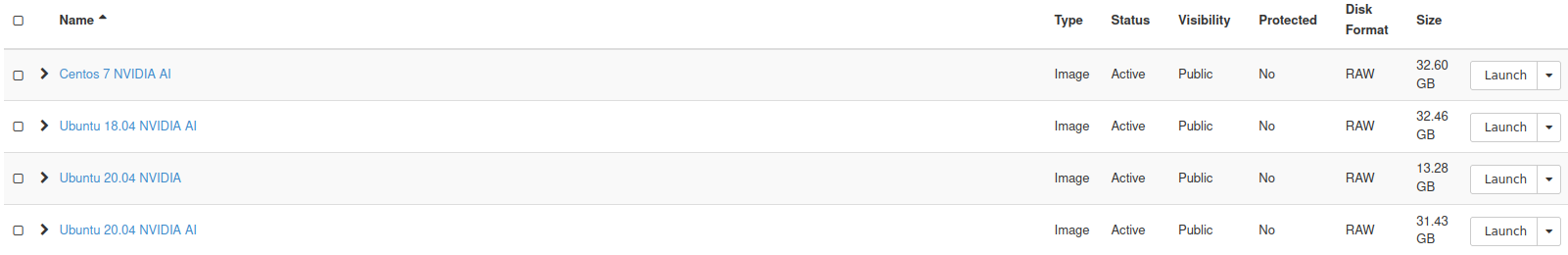

Darüber hinaus wurden auch vorkonfigurierte Images hinzugefügt.

Auf allen neuen NVIDIA-Images sind spezielle Treiber und CUDA-Tools vorinstalliert. Die NVIDIA AI-Images enthalten darüber hinaus Pakete zur Unterstützung des maschinellen Lernens, wie Tensorflow, PyTorch, scikit-learn und R.

Die Verwendung der folgenden Images ist obligatorisch, wenn eine neue virtuelle Maschine mit vGPU-Flavor gestartet wird. Andernfalls wird die virtuelle Grafikkarte möglicherweise nicht erkannt.

Nach dem Start einer virtuellen vGPU-Maschine durchzuführende Schritte

Verbinden Sie sich mit der virtuellen vGPU-Maschine, sobald sie erfolgreich gestartet wurde.

Um den Status des vGPU-Geräts zu überprüfen, geben Sie den Befehl ein:

nvidia-smi

Die Befehlsausgabe sollte Informationen über die verwendete GPU, die aktuelle Auslastung, die laufenden Prozesse und die Treiber- und CUDA-Versionen liefern.

Um die vGPU-Softwarelizenz zu prüfen, rufen Sie den Befehl auf:

nvidia-smi -q | grep -i license

Wenn eine Lizenz aktiv ist, zeigt die Befehlsausgabe den entsprechenden Status und das Ablaufdatum an.

root@vm01:# nvidia-smi -q | grep -i license

vGPU Software Licensed Product

License Status : Licensed (Expiry: 2022-10-20 12:40:45 GMT)

Weitere Informationen:

https://docs.nvidia.com/grid/latest/grid-vgpu-user-guide/index.html